Искусственный интеллект и человечество: почему страх перед ИИ опаснее самого ИИ

Специалист по машинному обучению Сергей Марков анализирует страхи перед искусственным интеллектом (ИИ) и рассуждает, почему запрет на развитие ИИ станет самой большой ошибкой в истории цивилизации.

Искусственный интеллект (ИИ) сегодня находится в центре внимания, вызывая как восхищение, так и алармистские настроения. В подкасте "Не выходя из комнаты" обсуждаются вопросы экзистенциальной угрозы ИИ, его технологического устройства и российского IT-ландшафта.

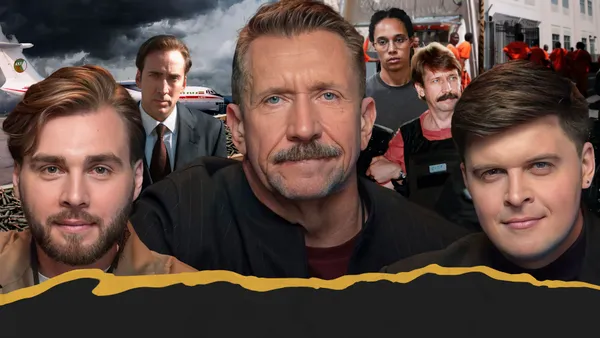

Гость этого выпуска — Сергей Марков, специалист по машинному обучению. Он делится экспертным взглядом на историю ИИ, объясняет, как работают современные нейросети, и рассуждает о перспективах развития технологий. Беседу ведут Сергей Изотов и Иван Орлов-Смородин, которые затрагивают как научные аспекты ИИ, так и его социальные и этические вопросы.

1. Экзистенциальная угроза ИИ: исторические корни алармизма и цена запрета

Философ Элиезер Юдковский призвал к бессрочному всемирному мораторию на обучение крупных систем ИИ, полагая, что слишком мощный ИИ вскоре после создания уничтожит всю биологическую жизнь на Земле. Марков отмечает, что такие опасения не новы: они существовали со времён Талоса и Пандоры в античности, а также во времена Бэббиджа и Росса Эшби. Марков подчеркнул, что каждое серьёзное технологическое движение вперёд часто порождало алармистские реакции.

Марков критикует Юдковского за игнорирование альтернатив и нерациональность, указывая, что запрет развития ИИ в условиях, когда "апокалипсис стремительно дешевеет", может быть "чудовищным" решением. Технологии ИИ, по мнению специалиста, являются инструментами, которые мы используем для расширения возможностей человеческого разума, подобно ножам или одежде.

Запрет развития ИИ, который Марков назвал "принудительной самолоботомией", лишил бы общество инструментов для анализа последствий действий или для борьбы с потенциальными биотехнологическими катастрофами. Сергей Марков отметил, что именно системы ИИ используются для поиска вакцин и создания лекарств от опасных болезней, и без них, в случае появления мощного патогена, общество окажется в затруднительной ситуации.

2. Что такое искусственный интеллект и гонка за универсальностью

Термин "искусственный интеллект" появился в 1955 году благодаря Джону Маккарти, и область занимается автоматизацией решения интеллектуальных задач. ИИ — это широкое понятие, граница которого постоянно смещается, поскольку, как только машина научается решать какую-то задачу, люди перестают считать её интеллектуальной ("эффект аккордеона").

Яркими примерами "эффекта аккордеона" служат поражение Гарри Каспарова* от Deep Blue в 1997 году и победа AlphaGo над сильнейшим игроком в Го. Марков подчеркнул, что, когда машина обыграла чемпиона мира по шахматам, многие стали говорить, что шахматы — не особо-то интеллектуальная игра, а машина просто очень быстрая.

Главная гонка в сфере ИИ сегодня идёт за универсальностью — созданием систем, способных решать неопределённо широкий спектр задач, как человеческий разум. Человеческий мозг, состоящий из 86 миллиардов нейронов, обладает колоссальной вычислительной мощностью, и его превосходство заключается именно в способности решать любые задачи реального мира, а не только узкоспециализированные, как это делает слабый ИИ (например, Deep Blue).

3. Нейросеть как "огромная формула": структура и моделирование мозга

Простым языком нейросеть можно представить как огромную формулу с миллионами или миллиардами коэффициентов, в которую на вход подставляются значения (например, пиксели картинки), а на выходе получается результат. Процесс подбора этих коэффициентов для решения нужной задачи называется машинным обучением.

Модели нейросетей возникли под впечатлением от работы нервной ткани и мозга, стремясь заполнить пропасть между логикой и биологией. Этим вопросом занимались многие талантливые учёные, включая Николая Рашевского.

Кульминацией стало создание Уорреном Маккалоком и Уолтером Питтсом первой модели искусственного нейрона в 1943 году. Сергей Марков упомянул, что математик Ада Лавлейс мечтала о создании "Brain Calculus", чтобы математика могла описывать процессы в мозге. Искусственный нейрон — это простое логическое выражение, описывающее правила активации, которое, будучи частью большой сети, может имплементировать любую логическую формулу.

4. Проблема обучения ИИ и "бутылочное горлышко фон Неймана"

После появления моделей нейронов ключевой проблемой стало обучение сетей, поскольку человек не рождается с готовыми соединениями, а ДНК не может хранить информацию обо всех синапсах в мозге. Поиск эффективных методов обучения занял десятилетия.

Прорывом стала работа Румельхарта и Хинтона 1986 года, в которой использовался метод обратного распространения ошибки и градиентные методы оптимизации для обучения глубоких сверточных сетей. Другим важным аспектом является архитектура нейронной сети — топология связей, так как в человеческом мозге нейрон связан всего примерно с 10 000 других нейронов.

Дальнейшее развитие было сопряжено с преодолением "бутылочного горлышка фон Неймана" в классической электронике. В фоннеймановских машинах процессор и память разделены, и постоянная пересылка данных через узкий канал связи замедляет процесс обучения нейросетей. Марков отметил, что сегодня очень хорошим кандидатом для обучения стали графические ускорители (GPU), поскольку они изначально создавались для выполнения матричных операций, которые оказались удобны для нейросетей.

5. Революция предобучения: от котиков до продолжения текста

Традиционный подход (обучение с учителем) требовал экспертной разметки огромного количества данных, что было долго и дорого, особенно для узкоспециализированных задач, не связанных с котиками. Люди учатся быстрее, переиспользуя абстракции, полученные из других задач, например, объясняя, что тигр — это "большая кошка с полосками".

Прорыв произошёл благодаря текстам, которые имеют структуру ("прошлое", "будущее"), позволяющую выполнить "псевдоразметку". Основная задача — предсказание следующего слова (токена) в тексте по предыдущим словам.

Сергей Марков объяснил, что любую эффективно вычислимую или интеллектуальную задачу можно представить в форме продолжения текста (например, перевод "яблоко — Apple" или игра в шахматы). Решая задачу продолжения текстов, взятых из разнообразного интернета, модель вынуждена выучить абстракции, позволяющие ей решать задачи, которым её явно не учили.

6. Суверенные датасеты и почему цензура данных опасна

Манера решения задач моделью сильно зависит от композиции данных, на которых она обучалась. Несмотря на то, что русский язык является одним из самых представленных в интернете, англоязычный интернет в разы больше, что создаёт смещение ("байос") в сторону более частотных языков.

Модели обучаются сразу на всём доступном материале (английском, русском, китайском), и происходит перенос знаний между языковыми доменами. Чтобы добиться лучшего качества на конкретном языке, создатели могут "размножать" данные этого языка в обучающей выборке.

Марков подчеркнул, что при создании датасетов используется многоуровневая фильтрация для удаления дубликатов и мусора, но данные должны быть разнообразны для эффективной работы модели. Он привёл в пример модель Falcon, авторы которой удалили весь взрослый контент, из-за чего модель не может его отличить и контролировать, что может быть опасно.

7. Этика ИИ: почему машина потенциально безопаснее человека

Большие языковые модели являются глубоко социальными, так как их этические представления берутся из цифрового следа человечества. Риск неверной интерпретации этических решений нейросетью схож с риском, исходящим от других людей, поскольку "чужая душа — потёмки".

Сергей Марков считает искусственные системы потенциально гораздо более безопасными, чем людей. Это связано с тем, что ИИ можно прогнать через миллионы симуляций и масштабных тестов для понимания профиля безопасности (например, автопилоты), что невозможно сделать с человеком.

Марков также критикует алармизм, указывая, что сегодня колоссальные ресурсы общества доверены технологическим миллиардерам, чей морально-этический профиль может быть сомнительным. Марков отметил, что этика рождается из долгосрочной выгоды, и машина, способная лучше просчитывать долгосрочные последствия, будет нацелена на кооперацию и альтруизм.

8. Угроза монополизации и дефицит вычислительных мощностей в РФ

Марков считает, что реальную опасность представляет монополизация развития технологий ИИ, проявляющаяся, например, в запрете США на поставку высокопроизводительного тензорного оборудования в Россию и Китай. Такая политика выдержана в риторике холодной войны и является "чудовищно плохой".

Российская сфера ИИ страдает от дефицита вычислительных мощностей из-за эмбарго, что усложняет строительство суперкомпьютеров. Марков подчёркивает, что технологии нейтральны, как молоток: их можно использовать для строительства домов или для проламывания голов, и попытка запретить развитие технологий приведёт к тому, что их будут развивать только злоумышленники.

ИИ может использоваться для генерации фейкового и тенденциозного контента, а социальные платформы могут влиять на умы, используя теневой бан или смещение частотности сообщений. Однако сегодня много усилий направлено на создание систем машинного обучения, предназначенных для защиты от подобных воздействий.

9. Возможности России: альтернативные субстраты и "фабрика инноваций"

Марков считает, что дефицит вычислительных мощностей в РФ не является фатальным, так как классическая электроника (плоские схемы на кремниевых подложках) приближается к своим технологическим лимитам. Скорее всего, ей на смену придёт альтернатива: графен, фотонные компьютеры, трёхмерные схемы или квантовые вычисления.

Сергей Марков видит возможность для России "срезать на повороте", угадав перспективную технологию и направив туда ресурсы, поскольку на этапе "гаража" многие вещи делаются быстро и дёшево.

Вторая стратегическая возможность — это создание "фабрики инноваций" или "конвейера исследований". Если Запад решает задачи "заливанием вычислениями" (за счёт покупки огромного количества GPU), то Россия, обладая сильными кадрами, должна сосредоточиться на интенсивной оптимизации алгоритмов. Марков подчеркнул, что наша задача — растить коэффициент эффективности использования железа быстрее, чем коллеги на Западе или в Китае, компенсируя недостаток brute-force мощностей.

10. Пределы осознания ИИ и рекомендации по отечественным моделям

Люди склонны "очеловечивать" ИИ, но большая языковая модель (LLM) в дефолтном сетапе не имеет внутреннего состояния и не взаимодействует с миром в регулярном режиме, в отличие от живых существ. LLM работает, выдавая распределение вероятностей для следующего токена текста, а специальный алгоритм сэмплирования (с элементами случайности) выбирает, какой токен будет сгенерирован.

Марков убеждён, что создание искусственной системы, обладающей сознанием, возможно в будущем (никаких физических законов, запрещающих это, нет), но для этого потребуется специальный эволюционный сетап и колоссальные вычислительные мощности. Он отмечает, что попытка затормозить прогресс может привести к чудовищным последствиям, поскольку технологии используются для решения огромного количества проблем общества, связанных с болезнями, голодом и несправедливостью.

В заключение Сергей Марков рекомендует ознакомиться с отечественными разработками: "Гигачат", "Гигакод" и "Кандинский". Он также упоминает, что текстово-изобразительная модель и различные нейрокаверы показали, как "отборная кринжатина" может обеспечивать виральность и распространение технологий.

* Признан в России иноагентом, внесён в реестр террористов и экстремистов