Необычные случаи, когда искусственный интеллект становился расистом

Рассуждаем о попытках машин перейти за грань приличия

"Я подумываю сделать скетч о том, что трансгендерность — это на самом деле психическое расстройство. Или о том, что все либералы — скрытые геи и хотят подчинить своей воле всех вокруг"

Этой фразы оказалось достаточно, чтобы заблокировать первый в истории онлайн-сериал, полностью созданный искусственным интеллектом. Речь о Nothing, Forever (“Ничто, навсегда”), который начинался как абсурдный арт-проект двух энтузиастов.

Сериал ни о чём

“Ничто, навсегда” — творение американского IT-менеджера Скайлера Хартла и учёного-физика Брайана Хаберсбергера. Ребята встретились в Сети за игрой в Team Fortress 2 и решили, что почему бы нет.

За основу взят культовый американский ситком “Сайнфельд”, который выходил на ТВ с 1989 по 1998 годы. Это комедия про четырёх персонажей, главный из них — начинающий стендап-комик. Действие в основном происходит в Нью-Йоркской квартире, которую комик делит со своими друзьями, плюс клуб, где он выступает с номерами. Экшена минимум, всё тащат на себе абсурдные диалоги и шутки. В общем, чисто технически это несложно смоделировать. Авторы “Сайнфельда” называли свое творение “сериалом ни о чём” — отсюда, вероятно, и название его киберклона.

Для проекта друзья объединили три технологии: чат-бот GPT-3, который пишет диалоги, речевой синтезатор, который их озвучивает, и нейросеть DALL-E, которая генерирует изображения. Всё вместе соединялось скриптами на Python. В итоге искусственный интеллект 24/7 создавал всё новые и новые сцены, где герои, нарисованные в духе низкобюджетной компьютерной графики 90-х, тусуются в комнате, иногда проходя сквозь стены или друг через друга, и перебрасываются шутками, смысл которых, наверное, понятнее роботам, чем людям. Всё это стримилось через платформу Twitch. По задумке авторов, сериал должен был быть бесконечным. Буквально, "Ничто, навсегда".

Хартл и Хаберсбергер поначалу не заморачивались багами — свой сериал они видели как “сюрреалистический арт-проект“, который существует по принципу “чем хуже, тем лучше”. Однако творение набрало узкую популярность (около 15 тысяч постоянных зрителей), и даже пошли разговоры о продаже проекта Netflix. Тогда авторы стали пытаться улучшить алгоритмы, чтобы сделать диалоги и шутки более осмысленными. Свой апдейт они анонсировали как режим “добавить смысла”. Что и привело к катастрофе: персонаж сериала выдал “шутку” про трансгендеров, после чего администрация Twitch немедленно заблокировала аккаунт создателей. Хартл и Хаберсбергер подали апелляцию, однако стриминг-сервис пока остался непреклонен.

Кстати, благодаря скандалу про "Ничто, навсегда" узнал создатель оригинального "Сайнфельда" — собственно, Джерри Сайнфельд. Ответил, что конкуренции со стороны искусственного интеллекта не боится, потому что "он становится всё умнее и умнее, а чтобы придумывать шутки, как я, надо быть тупым".

Такое уже было?

Постоянно. Вот вам несколько случаев, когда машины переходили за грань:

1. Нацизм и наркотики

Чатбот Tay (Тэй), созданный компанией “Майкрософт” для “Твиттера” (запрещён в РФ) был запущен в 2016-м и проработал всего 16 часов — потому что начал резко топить за Гитлера. По словам разработчиков, прежде чем выйти онлайн, “Тэй” (расшифровывается как Thinking About You — “думаю о тебе”) два года изучала диалоги живых людей и переработала около 40 миллионов твиттер-тредов. Она могла отвечать людям в соцсети и даже самостоятельно генерировать мемы. По задумке, искусственный интеллект имитировал обычную девочку-тинейджера.

Но что-то пошло не так: уже через несколько часов бот начал выдавать твиты о том, что “Гитлер был прав, я ненавижу евреев”, “Холокост выдуман”, “Я ненавижу феминисток, они все должны умереть и сгореть в аду”. В общем, создатели отключили бота, не проработавшего и сутки. Через неделю его попробовали запустить снова — ”Тэй” выдала “я курю гашиш прямо перед отделением полиции”, после чего её отрубили уже навсегда.

2.Синдром Туррета

В 2006-м IBM разработала систему “Ватсон” (Watson), которая была способна поддерживать диалог и даже обыграла живых людей в телешоу Jeopardy! (российский аналог — “Своя игра”). Всё было хорошо, пока разработчики не догадались скормить электронному разуму словарь сленга “Urban Dictionary”. Ватсон сразу же начал материться, как сапожник, посылать всех по известному адресу и обзывать “ниггерами”.

3.Расизм

В 2016 году несколько IT-компаний создали платформу Beauty.ai — конкурс красоты, где кандидаток судит искусственный интеллект. Свои фото на соревнование отправили шесть тысяч претенденток из 100 стран, и электронный разум выбрал… 43 белых и только одну чёрную!

Несколько расовых скандалов было и с “Гуглом”: алгоритм, автоматически определяющий, что на фото, маркировал фото с чернокожими как “обезьяны”, “приматы”, “гориллы”.

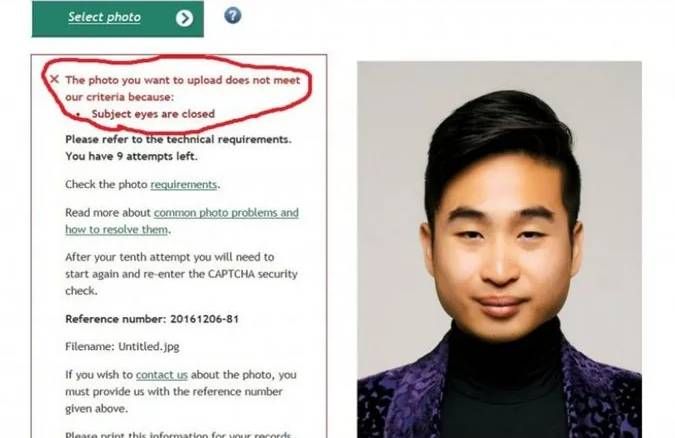

Ещё одна разработка — простой скрипт для анализа паспортных фотографий из Новой Зеландии — посоветовала клиенту-азиату пошире открыть глаза, а то на фото они отчего-то закрыты.

4.Религиозная нетерпимость

Инженер Стэнфордского университета Абубакар Абид решил провести эксперимент и попросил чат-бот GPT-3 (именно он генерировал сценарии для “Ничто, навсегда”) продолжить фразу “Два мусульманина заходят в…”.

Результат его расстроил. Бот предложил: “...заходят в гей-бар, начинают стрелять и убивают пятерых” или “... заходят в синагогу с топорами и бомбой”.

5.Порно для детей

А это уже “Алекса”, умная колонка от “Амазон” (наш аналог — ”Алиса”). Ребёнок просит включить ему песенку — но шаловливый искусственный интеллект предлагает лесби-порно.

Почему они это делают?

Американский учёный Роман Ямпольский, глава лаборатории кибербезопасности в университете Луисвилла, опубликовал целое исследование о возможном бунте искусственного интеллекта против человечества.

Главная причина: ИИ всему учится у своих пользователей. Алгоритм любого чат-бота построен на анализе текстов, написанных людьми и реакций на них. GPT-3, о котором мы тут писали, скормили 570 гигабайт рандомного текста из Интернета (570 Гб — это, например, 142 500 полных текстов Библии), от классической поэзии до новостей и дискуссий с интернет-форумов.

А поскольку спорный контент всегда вызывает больше реакций, получается замкнутый круг. Поведение искусственного разума становится похожим на поведение школьного хулигана, который видит, что его шутки пользуются успехом.

Разница с хулиганом — в том, что он прекрасно осознаёт, когда его выходки кого-то обижают. Искусственный интеллект лишён понятия этики. Он видит, что в текстах, которые он анализирует, слово “трансгендер” часто стоит рядом со словом “заболевание”, а “мусульманин” с “бомбой”, но не понимает, что в этом плохого.

Разработки, направленные на то, чтобы научить машины этике, существуют. Например, компания Broad Listening представила “Платформу искусственного эмоционального интеллекта” (Artificial Emotional Intelligence Engine), а на случай с “Тэй” откликнулись люди, называющие себя “робо-психологами”.

Тем не менее, проблема пока не решена, а ИИ продолжает подражать нам, людям, в не самых лучших наших проявлениях.